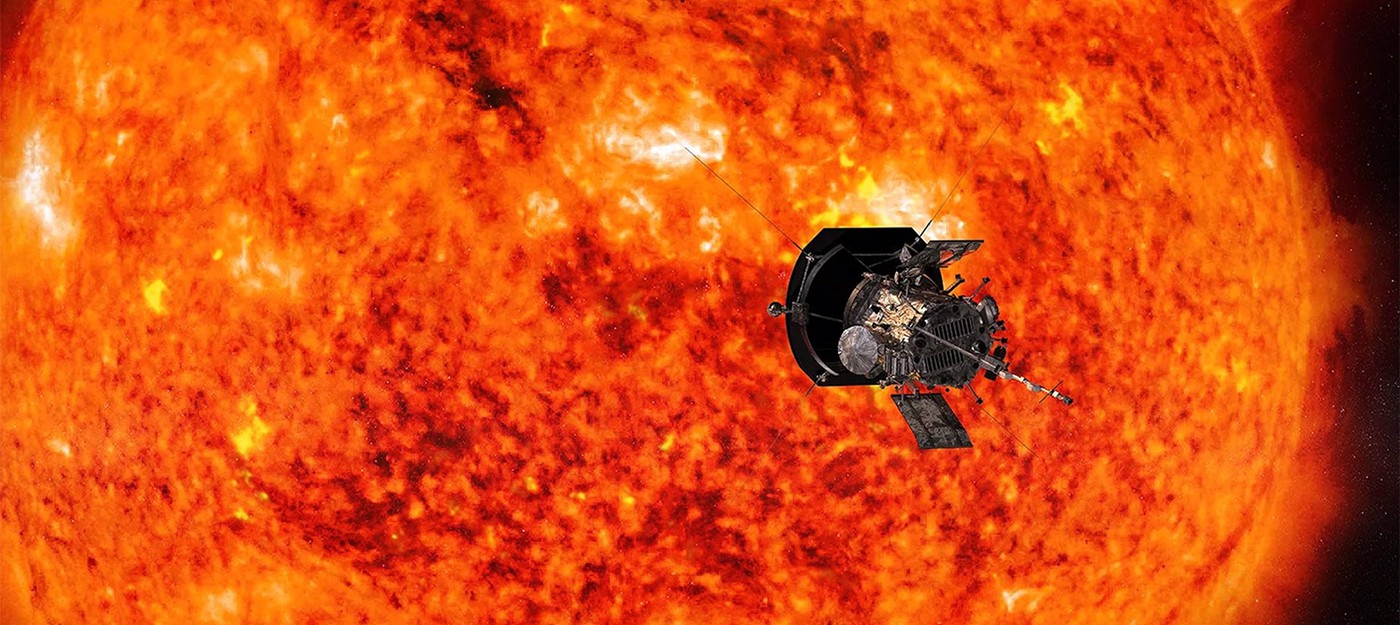

BepiColombo передал детальные снимки скрытой поверхности Меркурия

Космический аппарат BepiColombo, созданный совместными усилиями Европы и Японии, прислал уникальные фотографии ближайшей к Солнцу планеты. Во время последнего пролета зонд смог заглянуть в постоянно затененные кратеры Меркурия, скрытые от прямых солнечных лучей.В прошлую среду BepiColombo, состоящий из двух соединенных космических аппаратов, совершил шестой и финальный пролет мимо Меркурия. Гравитационный маневр помог скорректировать траекторию для выхода на орбиту планеты в 2026 году. Миссия стартовала в октябре 2018 года как партнерский проект Европейского космического агентства (ESA) и Японского агентства аэрокосторских исследований (JAXA).Во время последнего сближения аппарат пролетел на . . . .